本文摘要:摘要:针对传统的图像描述模型不能充分利用图像信息且融合特征方式单一的问题,提出了一种融合自适应常识门的图像描述生成模型。首先,使用VCR-CNN提取视觉常识特征,并将常识特征分层输入到Transformer编码器中;然后,在编码器每一分层中设计了自适应常识门,对视觉常

摘要:针对传统的图像描述模型不能充分利用图像信息且融合特征方式单一的问题,提出了一种融合自适应常识门的图像描述生成模型。首先,使用VCR-CNN提取视觉常识特征,并将常识特征分层输入到Transformer编码器中;然后,在编码器每一分层中设计了自适应常识门,对视觉常识特征和编码特征进行自适应融合操作;最后,将融合常识信息的编码特征送入Transformer解码器中完成训练。通过MSCOCO数据集进行训练和测试,在指标BLEU-4、CIDEr、SPICE分别为39.2、129.6和22.7,相较于POS-SCAN模型分别提升了3.1%、2.9%和2.2%。实验结果表明,所提出的模型效果明显优于使用单一显著区域特征的Transformer模型,能够对图像内容进行准确的描述。

关键词:图像描述;自然语言处理;卷积神经网络;视觉常识;自适应常识门

0引言

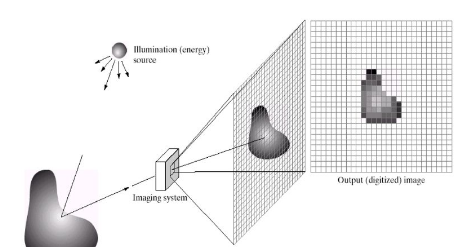

图像描述生成是一个融合了计算机视觉和自然语言处理的跨模态任务,它是图像处理的高级层次。从传统基于检索、模板的方法到后来基于编码器-解码器的深度学习方法[1-2],使图像描述生成任务从只能生成单一形式的语句发展到现在可以生成精度更高、描述更加准确的语句。在常规的编解码框架中,使用了卷积神经网络(ConvolutionalNeuralNetwork,CNN)[3]作为编码器将图像编码为相应特征,使用长短期记忆(LongShort-TermMemory,LSTM)网络作为解码器将图像特征解码为对应描述句子。

2017年,Vaswani等[4]提出了一种完全依赖于注意力机制的Transformer结构,可以对图像特征进行关系建模,解决了循环神经网络(RecurrentNeuralNetworks,RNN)存在的时间依赖问题。随后,基于Transformer结构的各种变体[5],[6]在图像描述模型中应运而生。2018年Anderson等[7]首次采用FasterR-CNN(FasterRegion-basedConvolutionalNeuralNetwork)[8]作为编码器,提取图像的显著区域特征并应用在图像描述生成模型中,一经问世便取得了极其优秀的表现。

2019年,Herdade等[9]在Transformer结构之上,通过几何注意合并对象事物之间的空间关系信息,证明了模型空间意识的重要性。以上的图像描述生成模型虽然能产生描述图像语义内容的句子,但无法确切描述图像事物的因果关系,存在潜在的视觉注意不合理问题。2020年,Wang等[10]提出了一种新的无监督特征表示学习方法,设计了VCR-CNN(VisualCommonsenseRegion-basedConvolutionalNeuralNetwork),该网络通过因果关系训练得到视觉常识特征,可以捕捉图像中上下文之间的潜在关系,在图像描述生成模型上取得了很好的表现。

现在的图像描述生成模型在使用多个特征进行融合处理时,会出现特征信息利用不充分且融合方式单一的问题,存在一定的局限性。文献[10]从图像中提取视觉常识特征,但只是单一拼接到显著区域特征上训练,并未充分利用视觉常识性信息。文献[11]使用了VGG(VisualGeometryGroup)19和ResNet(ResidualNetwork)作为特征提取网络,整体融合方式也只是单一拼接,没有重点融合其中的关键信息,导致生成语句存在重要内容缺失问题。

本文提出了基于Transformer结构的图像描述生成模型,引入了一种全新的自适应常识门机制。为了提高对图像深层关系的感知和表征性,提取视觉常识特征分层输入到Transformer编码器中,使模型更好的从特征信息中感知图像的因果关系。为了增强常识信息在Transformer结构上的利用效果并提高网络收敛速度,本文改进了两种特征之间单一拼接的方式,在每一分层上设计了自适应常识门(AdaptiveCommonsenseGate,ACG)。这样不仅可以降低模型收敛速度,而且能够充分融合视觉常识信息和图像编码信息,生成更加符合语境的描述语句。

1模型架构

为了更好的实现并行处理,提高图像描述的准确度,模型使用了目前流行的完全基于注意力机制的Transformer结构,并在此基础上重新设计了网络。模型大体分为三个部分:特征提取网络、融合ACG的编码器、解码器。其中,编码端由多个自注意力块和ACG堆积组成:自注意力块负责对图像特征进行聚合操作,以此得到更高层次的图像特征;ACG负责融合视觉常识特征和图像编码特征,自适应地决定两者特征之间的权重。解码端由多个掩码自注意力块和交叉注意力块组成,负责对编码图像进行解码操作,通过迭代解码预测图像标题。

1.1特征提取网络

通过目标检测任务中的FasterR-CNN提取图像的显著区域特征以及VCR-CNN提取图像的视觉常识特征。FasterR-CNN将区域建议网络(RegionProposalNetwork,RPN)引入深度神经网络中,将最终层提取的图像特征组合为显著区域特征Vvvv=12,,,…。

VCR-CNN作为一种改进的视觉区域编码器,使用因果关系干预该区域的上下文对象,可以学习感知构建知识。VCR-CNN通过干扰因子字典(ConfounderDictionary,CD)存储常识,它的实现和FasterR-CNN相比,去除了RPN网络,不再训练网络建议边界框,而是直接将训练集中真实词的边界框坐标输入到其中,直接提取区域特征。

1.2融合ACG的编码器

设计自适应常识门的动机来源于文献[12]中的门控机制,在许多计算机视觉任务中得到了广泛的应用。采用门控机制的目的是建立信道特征依赖关系,可以更加有效地指导多通道信息之间的交互。ACG通过后续层和自注意力块相结合,以此在编码器中以同质方式对图像模态间和模态内的常识性关系进行建模。

2实验准备

2.1实验数据集以及训练环境

本文使用MSCOCO2014[13]数据集来验证模型性能。MSCOCO数据集是当前图像描述任务的最大离线数据集,其包括82783个训练图像,40504个验证图像和40775个测试图像,每个图像标有5个标题。离线“Karpathy”数据分割[14]用于离线性能比较,这种分割在图像描述工作中得到了广泛的应用,其中113,287张带有5个标题的图像进行训练,并用5000张图像用于验证,5000张图像用于测试。实验环境在Windows操作系统下进行,基于Pytorch深度学习框架,该框架支持GPU运算;用于测试的环境为Python3.7;用于训练和测试的硬件配置为:Inteli7-9700CPU3.00GHz处理器,NVidiaGeForceGTX2080显卡。

2.2评分标准

为了对所提出的模型方法进行定量的性能评价,实验采用了标准的客观量化评分方法,其中包括BLEU(BiLingualEvaluationUnderstudy)、ROUGE_L(LongestcommonsubsequencebasedRecall-OrientedUnderstudyforGistingEvaluation)、METEOR(MetricforEvaluationofTranslationwithExplicitORdering)、CIDEr(Consensus-basedImageDescriptionEvaluation)[15]以及SPICE(SemanticPropositionalImageCaptionEvaluation)[16]等评价指标。

2.3实验参数设置

参数设置方面,本文在编码器和解码器中使用N=3个相同的层。单词嵌入层的输出维数为512,输入的视觉特征也通过线性投影映射到512。前馈网络的内层维数为2048。多头注意采用=8个平行注意层。本文使用ADAM(ADAptiveMomentestimation)[17]优化器训练,将beta1和beta2分别设置为0.9和0.999,epsilon设置为1e-6。在语言文本生成模型中设定单词时间步为20,为了生成更加合理的图像文字描述,本文采用集束搜索BeamSearch的方式,将beamsize大小设置为3。

为了增强模型的鲁棒性以及提高模型的训练速度,分别使用预先训练的FatserR-CNN模型提取图像的显著区域特征,使用VCR-CNN模型提取图像对应视觉常识特征。训练中,本文设置模型学习速率初始化为3e-4,输入批处理大小为10,每次训练5轮增加0.05的计划抽样概率,进行15轮交叉熵损失训练;随后使用SCST(Self-CriticalSequenceTrainingforimagecaptiongeneration)[18]强化学习方法训练,学习率大小设置为1e-5,训练至30轮结束。

3实验结果及分析

为了验证提出的融合自适应常识门的图像描述模型表现和性能。

3.1实验结果定性分析

本文选取测试集中不同场景的图像进行测试,各图生成的描述实例,其中每个实例包含Transformer基线模型、本文模型以及人为标注的参考描述(HUMAN)。从这些示例中,本文发现Transformer基线模型生成的标题符合语言逻辑,但描述内容不够准确,甚至有些描述与图像内容不太匹配。

而本文提出的模型生成的标题相对正确且更具有描述性。从中可以看到本文提出的模型生成的语句不仅相比基线模型效果要更好,甚至比人工描述更加生动形象,描述出了人工标注也忽略了的一些重要点。然而,相对于表达程度更深的人工标注而言,机器产生的描述存在一定的局限性。本文模型和Transformer基线模型仅仅只是描述出图像中的内容“一组飞机停在机场”,而人工标注进一步描述出了“在窗户后面”。

4结语

本文提出了一种基于Transformer结构,融合自适应常识门的图像描述生成模型。使用FasterR-CNN模型提取图像显著区域特征,使用VCR-CNN模型提取视觉常识特征。通过将视觉常识特征分层输入到Transformer编码器中,并在每一分层中设计使用了自适应常识门,从而增强了模型对视觉常识信息的提取能力,同时进一步融合了图像的显著区域信息和视觉常识信息。本文所提出的模型在图像描述评价指标上都取得较高分数,其中BLEU-4、CIDEr得分可以达到39.2分和129.6分。实验结果表明,本文提出的模型泛化能力相比于传统模型更好一些,在图像描述生成任务上能取得出色的表现。

参考文献:

[1]JiangW,MaL,JiangYG,etal.Recurrentfusionnetworkforimagecaptioning[C]//Proceedingsofthe2018EuropeanConferenceonComputerVision.Cham:Springer,2018:499-515.

[2]黄友文,游亚东,赵朋.融合卷积注意力机制的图像描述生成模型[J].计算机应用,2020,40(1):23-27.(HUANGYW,YOUYD,ZHAOP.Imagecaptiongenerationmodelwithconvolutionalattentionmechanism[J].JournalofComputerApplications,2020,40(1):23-27.)

[3]HEK,ZHANGX,RENS,etal.Deepresiduallearningforimagerecognition[C]//Proceedingsofthe2016InternationalConferenceonComputerVisionandPatternRecognition.Washington,DC:IEEEComputerSociety,2016:770-778.

[4]VASWANIA,SHAZEERN,PARMARN,etal.Attentionisallyouneed[C]//Proceedingsofthe31stInternationalConferenceonNeuralInformationProcessingSystems.RedHook,NY:CurranAssociatesInc,2017:6000-6010.

[5]ZHUX,LIL,LIUJ,etal.CaptioningTransformerwithStackedAttentionModules.AppliedSciences.2018;8(5):739.

作者:杨有1,2,陈立志2*,方小龙2,潘龙越2

转载请注明来自发表学术论文网:http://www.fbxslw.com/dzlw/29279.html